Los motores de búsquedas son cada vez más inteligentes, pero a veces es necesario ofrecer un poco de ayuda para que los robots sepan dónde ir. Y eso es lo que hacen los Sitemap XML.

¿Qué es un sitemap XML?

Un sitemap XML es una parte importante de la optimización de cualquier sitio web. Son archivos en los que se proporciona información sobre las páginas, post, imágenes y otros archivos de tu sitio web.

No solo proporciona a los robots una lista completa de todas las páginas públicas de un sitio web. Del mismo modo, les da a los motores de búsqueda una mejor idea de la arquitectura de información del sitio web, la jerarquía de sus páginas y la frecuencia de actualización de los contenidos.

Ventajas de implementar un sitemap XML

Generar un sitemap XML y enviarlo a los motores de búsqueda es uno de los pasos más importantes que puede seguir para asegurarse de que su sitio web esté indexado correctamente. Por tanto, las principales ventajas de tener un mapa de sitio actualizado son:

- Mejora la indexación, ya que el enviar las URL es más fácil facilitar su importancia para su inclusión en el índice de Google.

- Mejor priorización de rastreo. Por ejemplo, si el sitemap está escrito en cascada es más probable que los motores de búsqueda asignen un mayor peso de clasificación a las URL que están más arriba en la jerarquía de contenido de su sitio web que a las que están más abajo.

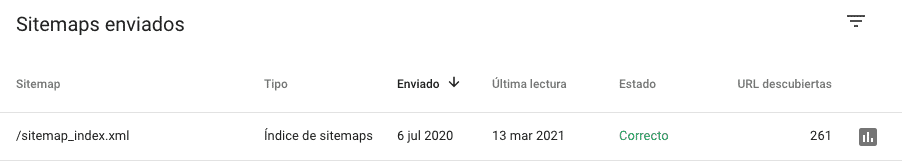

- Detectar errores a través de herramientas como Search Console. Crear el sitemap y enviarlo a Google Search Console no solo le permite a Google encontrarlo más fácilmente, sino que también nos permite saber qué URLs están correctas y detectar posibles errores para solucionarlos.

Cómo crear un mapa del sitio XML

Hay varias formas de generar un sitemap, las principales son:

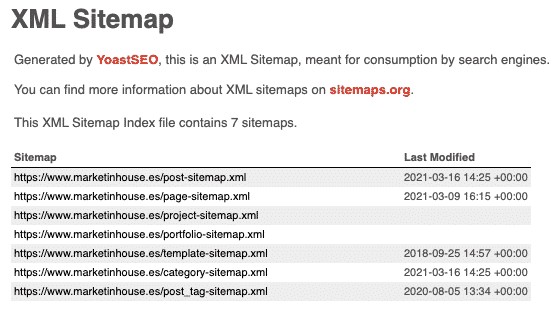

- A través de un CMS. Algunas plataformas como WordPress tienen funciones de SEO que incluyen generadores de sitemap XML. Además, existen también complementos como, por ejemplo Yoast, que tiene uno de los mejores generadores de mapas de sitio.

- Usando un generador en línea como XML Sitemaps Generator

- Crearlo a mano siguiendo las pautas de Google para obtener mejores resultados y evitar errores.

Un sitemap debe ser un elemento vivo, por lo que deberemos optimizarlo en base a los contenidos que se añadan o desaparezcan del sitio web.

Cómo ayudar a los motores de búsqueda a encontrar el sitemap

En primer lugar, enviándolo a través de Google Search Console. Además de ayudar a los motores de búsqueda a encontrar el sitemap de una web, estas plataformas también proporcionan información y diagnósticos sobre las URLs que figuran en él.

En segundo lugar, también es bueno incluir la URL en el archivo Robots.txt para que los motores de búsqueda conozcan la ubicación del sitemap XML.

Puntos a tener en cuenta para optimizar el sitemap de una web

Eliminar URL innecesarias y priorizar páginas de alta calidad

Es bastante común tener páginas activas que no queremos indexar, ya sea por contenido duplicado, paginaciones SEO, etc.

No incluir URL rotas ni redireccionadas en el mapa del sitio

Esto puede resultar muy obvio, pero en muchos casos se nos puede pasar realizar el cambio en caso de redirecciones web. Por eso, es importante, verificar con herramientas como Screaming Frog los códigos de estado de cada una de las URL prestando atención a los siguientes valores:

- 3xx redirecciones. Estas respuestas del servidor significan que la URL ha sido redirigida. Si este es el caso, es mejor quitar la URL del mapa del sitio y añadir la URL final a la que apunta.

- Errores 4xx. Estas respuestas del servidor significan que la página que visita no existe o tiene problema. Si se ha eliminado y es permanente, hay que quitar esa URL del sitemap XML.

- 5xx prohibido. Algunas páginas requieren inicio de sesión para acceder. Dado que los robots de los motores de búsqueda no pueden hacerlo, simplemente recibirán un mensaje de prohibido. Si alguna de estas páginas aparece en el sitemap, hay que eliminarlas.

Incluir solo versiones canónicas de las URL

Al igual que ocurría en el punto anterior, algunas páginas pueden no ser indexables debido a etiquetas HTML especiales, como es el caso de páginas canonicalizadas. Revisa que no tengas ninguna URL en el sitemap con la etiqueta Rel = canonical apuntando a otra página.

Utilizar la metaetiqueta Robots en lugar de Robots.txt siempre que sea posible

Como norma general, cuando no queramos indexar una página, debemos definir la etiqueta meta robots “noindex, follow” en el código html de la página. Esto evita que Google indexe la página, pero conserva el valor de los enlaces.

Si se ve que indexa y consume presupuesto de rastreo, en ese caso, se podría valorar desindexarlo a través de robots.txt

No incluir URL “noindex” en el mapa del sitio

Algunas páginas del mapa de sitio pueden no ser indexables debido a etiquetas HTML especiales. Este seria un claro ejemplo de presupuesto de rastreo desperdiciado. Si los robots de los motores de búsqueda no pueden indexar ciertas páginas, entonces no tienen sentido que estén incluidas en el sitemap de una web.

Supervisar los informes de Search Console

Como hemos comentado, Search Console tiene un informe de sitemaps que proporciona mucha información útil sobre el estado del mapa del sitio y las páginas enumeradas en él.

Podemos obtener un informe detallado de los siguientes valores:

- Correcto: el sitemap se ha cargado y se ha procesado correctamente y sin errores.

- Tiene errores: el sitemap se ha podido analizar, pero tiene algunos errores.

- No se ha podido obtener: no se ha podido obtener el sitemap por algún motivo.

En conclusión, echar un vistazo a su informe de sitemaps en Search Console permite detectar rápidamente los problemas a solucionar.